/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

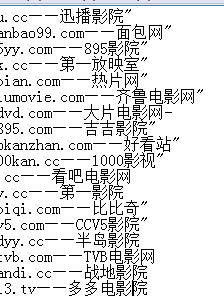

Url采集(含站长扩展搜索)是一款关键词url批量采集脚本,除开热门的百度相关搜索词采集,当然还有360搜索引擎以及搜狗搜索引擎,多线程关键词采集URL,需要走代理,不然会出验证。

先导入关键词到key.txt文档,在运行软件

多线程搜索关键词提取

Url采集是一个非常专业易用的关键词url批量采集脚本,含站长扩展搜索,包括热门的百度相关搜索词、360搜索引擎、搜狗搜索引擎采集,提供多线程搜索关键词提取,使用的时候只需要先导入关键词到key.txt文档,在运行软件,就可以批量采集关键词url,非常简单,网站优化必备小神器哦~

程序主要运用于安全渗透测试项目,以及批量评估各类CMS系统0DAY漏洞的影响程度,同时也是批量采集自己获取感兴趣的网站的一个小程序~~

测试环境为 Python 2.7.x 如果需要python3版本的,可以自行修改,或者我的博客留言

目前只可以采集百度搜索引擎的结果。并且每页默认显示50条记录。可自定义输入要采集的页数。

如果要采集关键词为“hacker”的相关网站,采集百度结果的前3页,则输入如下:

please input keyword:hacker

Search Number of pages:3

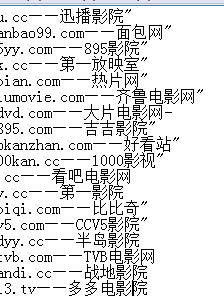

1:Url采集工具获取到的是百度搜索结果的真实URL地址

2:可以忽略不需要的常见网站,如忽略百度翻译,等等所有百度相关结果,给数组添加baidu.com即可。程序已经默认忽略了很多条啦,如

filter_array1 = ['baidu.com','sina.com.cn','sohu.com','taobao.com','douban.com','163.com','tianya.cn','qq.com','1688.com']

filter_array2 = ['ganji.com','58.com','baixing.com']

filter_array3 = ['zhihu.com','weibo.com','iqiyi.com','kugou.com','51.com','youku.com','soku.com','acfun.cn','verycd.com']

filter_array4 = ['google.cn','youdao.com','iciba.com','cdict.net']

filter_array5 = ['pconline.com.cn','zcool.com.cn','csdn.net','lofter.com']

3:实时显示采集到的网页的【真实URL】以及【标题】。前面的【ID】对应的是当前页百度结果的第X条数据

4:自动保存结果到当前目录的txt文件,文件名为搜索的 关键词.txt 为了方便导入到其他工具,txt文件里面只记录了采集的网址。如果需要同时记录标题,把代码中的注释删除即可

5:自动去除重复记录

6:统计总采集条数(143 found),有效的条数(91 checked),被过滤的条数(52 filter),以及被过滤的重复的URL条数(9 delete)

7:开源,任何人都可以下载使用。由于本人能力有限,如果有好的建议以及修改,也希望能一起完善

8:跨平台,并且无捆绑后门风险。以前网上有的百度URL采集软件大部分为WINDOWS下的可执行文件,并且现在百度更新后无法正常采集。

9:程序会不断更新

uninstall tool密钥最新版网络辅助

/ 1K

uninstall tool密钥最新版网络辅助

/ 1K

diskgenius离线激活码永久版网络辅助

/ 37M

diskgenius离线激活码永久版网络辅助

/ 37M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

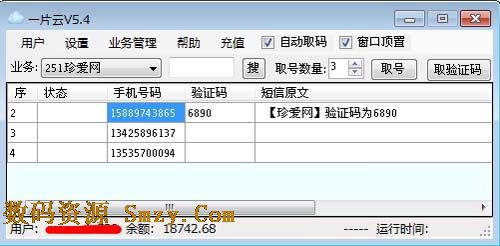

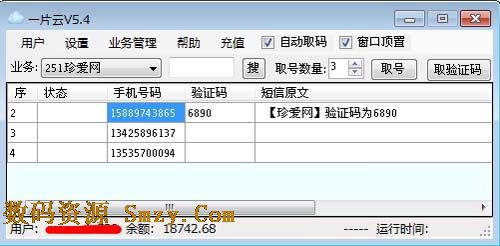

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

uninstall tool密钥最新版网络辅助

/ 1K

uninstall tool密钥最新版网络辅助

/ 1K

diskgenius离线激活码永久版网络辅助

/ 37M

diskgenius离线激活码永久版网络辅助

/ 37M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M