/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

有朋友和小编抱怨说,大批量采集网页很麻烦。其实是您没有选择对方法。例如使用这款独品网页批量采集,就是一个非常简单的方法。因为这款网页采集器自带网页分析工具、函数编辑工具,可自定义过滤条件采集方式,速度快,精确度高。而且独品网页批量采集还支持循环地址,按标题保存、任务引用、自定义函数。给您的网页批量采集带来帮助!

采集小说文章、软件链接、视频音乐,可全站查找、按搜索关键字查找等。

链接地址:可以是单个地址也可以循环地址,还可以是其他任务采集到的所有链接地址。

采集命令:命令分为两部分,前一部分为指定区域,后一部分指定内容,如:<div class=t_f><img src=>(独品论坛贴内图片)、<div class=top><text>(区域内文本)

链接过滤、采集过滤:均使用函数过滤,自带常用过滤函数find、notfind、findin、notfindin,使用:find(<title><text>,贴图鉴赏)、notfind(value,image/face)

执行参数:涉及到采集完成后自动下载、按网页标题保存、文件重复时跳过、是否保留到IE缓存等

采集discuz、phpwind等论坛博客贴内大图、贴内文章、贴内链接,可限定版块或排除版块,还可以指定发帖作者、帖子内容等。

uninstall tool密钥最新版网络辅助

/ 1K

uninstall tool密钥最新版网络辅助

/ 1K

diskgenius离线激活码永久版网络辅助

/ 37M

diskgenius离线激活码永久版网络辅助

/ 37M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

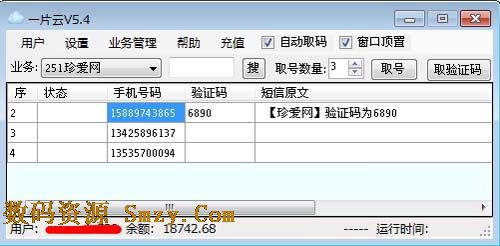

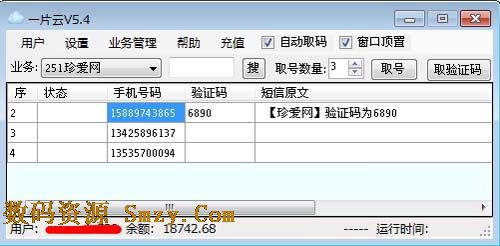

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

吉吉影音资源BT种子(吉吉影音看片网站) 免费版网络辅助

/ 397K

uninstall tool密钥最新版网络辅助

/ 1K

uninstall tool密钥最新版网络辅助

/ 1K

diskgenius离线激活码永久版网络辅助

/ 37M

diskgenius离线激活码永久版网络辅助

/ 37M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

守望先锋dva本子完整版(内含视频) 高清网盘版网络辅助

/ 1M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

友邦微信群发软件(微信推广工具) v5.7 最新版网络辅助

/ 27.84M

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

网页自动点击操作助手电脑版(自动刷网页点击数) v19.1.0 免费版网络辅助

/ 8M

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

CDR注册机(cdr永久激活代码) 免费版网络辅助

/ 323K

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

360种子在线编辑器(360种子洗白工具) v1.0.1 绿色免费版网络辅助

/ 1M

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

一片云验证码平台(验证码接收工具) v6.4 官方最新版网络辅助

/ 1004K

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M

奥维互动地图vip账号分享工具(奥维地图vip账号大全) v2017 免费版网络辅助

/ 28M